Аннотация

Классификация медоносных пчел по геометрической морфометрии крыльев предполагает, прежде всего, ручную аннотацию 19 ориентиров в местах соединения вен переднего крыла. Это занимает много времени и чревато ошибками, что сказывается на точности классификации. Здесь мы разработали программное обеспечение под названием DeepWings©, которое позволяет преодолеть это ограничение в классификации геометрической морфометрии крыла путем автоматического обнаружения 19 ориентиров на цифровых изображениях правого переднего крыла. Мы использовали базу данных, содержащую 7634 изображения переднего крыла, включая 1864, проанализированных Ф. Раттнером в оригинальной работе по выделению 26 подвидов медоносной пчелы, для настройки сверточной нейронной сети в качестве детектора крыльев, U-сети глубокого обучения в качестве сегментатора ориентиров и машины опорных векторов в качестве классификатора подвидов. Реализованный детектор крыльев MobileNet смог достичь mAP 0,975, а сегментатор ориентиров смог обнаружить 19 ориентиров с точностью 91,8%, со средней точностью позиционирования 0,943, что соответствует аннотированным вручную ориентирам. Классификатор подвидов, в свою очередь, показал среднюю точность 86,6% для 26 подвидов и 95,8% для подмножества из пяти важных подвидов. Окончательная реализация системы показала хорошие скоростные характеристики, потребовав всего 14 с для обработки 10 изображений. DeepWings© очень удобна в использовании и является первым полностью автоматизированным программным обеспечением, предлагаемым в качестве бесплатного веб-сервиса, для классификации медоносных пчел по геометрической морфометрии крыльев. DeepWings© может использоваться для разведения медоносных пчел, охраны природы и даже в научных целях, поскольку предоставляет координаты ориентиров в формате excel, облегчая работу исследовательских групп, использующих классические подходы к идентификации и альтернативные аналитические инструменты.

1.Введение

Западная медоносная пчела (Apis mellifera L.) дифференцируется на 31 подвид в своем родном ареале в Евразии и Африке [1,2,3,4]. Подавляющее большинство этих различий было распознано еще отцом таксономии медоносной пчелы Фридрихом Руттнером, который выделил 24 подвида, используя 36 морфологических признаков, полученных из волосистости, пигментации, длины различных частей тела и жилкования крыльев. Анализ 36 признаков до сих пор является золотым стандартом классификации медоносных пчел и необходим для научных целей, например, для описания новых подвидов [5]. Однако измерение и анализ всех 36 признаков является трудоемким и требует экспертных знаний, что делает классическую морфометрию непригодной для идентификации колоний в коммерческих, природоохранных или даже научных целях. Чтобы обойти это ограничение, недавно были предприняты усилия по упрощению и автоматизации идентификации подвидов медоносной пчелы [6,7,8,9]. Тем не менее, инструмент для простой, быстрой и недорогой классификации медоносных пчел остается недоступным для использования пчеловодческим сообществом.

Здесь мы использовали инструменты машинного обучения для разработки программного обеспечения с открытым исходным кодом DeepWings©, которое поможет пчеловодам, заводчикам маток, а также исследователям идентифицировать подвиды медоносных пчел по геометрической морфометрии крыльев полностью автоматически, быстро, легко и бесплатно. Этапы разработки DeepWings© подробно описаны в следующих разделах, в то время как в оставшейся части раздела «Введение» представлен современный уровень идентификации медоносных пчел с помощью методов, основанных на морфологии, с акцентом на признаки венчика крыла. Раздел «Материалы и методы» начинается с моделирования установки для получения окончательного решения. Затем описываются изображения крыльев, а также этапы создания наборов данных, используемых для обучения, включая увеличение данных для решения проблемы небольшого набора данных крыльев, используемых для обучения классификации. В последующих подразделах подробно описаны методы, задействованные на трех основных этапах архитектуры DeepWings©. Первый этап (предварительная обработка) включает в себя обработку необработанных изображений крыльев с помощью CNN, что подразумевает применение фильтров, обнаружение крыльев, их обрезку и нормализацию размера крыльев. Общий подход позволяет анализировать изображения с широким диапазоном вариаций относительно визуальных артефактов, шума, позы и освещения, а также содержащие различное количество крыльев. На втором этапе (определение ориентиров) происходит обнаружение (с помощью U-сети), извлечение и сортировка таксономически информативных признаков (ориентиров) на изображениях крыльев, сегментированных на предыдущем этапе. На третьем этапе (классификация) извлеченные ориентиры подвергаются нормализации по Прокрусту, которая обрабатывает инварианты перевода, вращения и масштаба крыла, прежде чем попасть в SVM-классификатор. В разделе «Результаты и обсуждение» оценивается эффективность методов, задействованных на трех этапах архитектуры, и проводится сравнение DeepWings© с другими инструментами классификации на основе крыльев. В этом разделе также представлена реализация DeepWings© в виде веб-сервиса, его атрибуты и его многочисленные применения в реальном мире. Работа завершается основными выводами в разделе «Заключение».

Справочная информация

Классическая морфометрия была заменена трудоэффективными альтернативами, основанными на модели формы передних крыльев, которые обычно оцениваются на рабочих особях медоносных пчел (бесплодных самках). Передние крылья, а именно места соединения вен, несут в себе высокую информативность и поэтому имеют большое значение для идентификации подвидов медоносной пчелы [5,10,11,12]. Эта особенность, а также квазидвумерная структура передних крыльев, делает эту часть тела хорошо подходящей для компьютеризации и автоматизации классификации медоносных пчел с помощью анализа изображений.

Набор признаков переднего крыла по отдельности или в сочетании друг с другом используется для идентификации подвидов медоносной пчелы [5]. Среди них кубитальный индекс, индекс хантеля и угол дисковидного сдвига [13], которые могут быть измерены на изображениях крыльев с помощью полуавтоматического программного обеспечения CBeeWing (https://www.cybis.se/index.htm; доступ получен 26 апреля 2022 года). Это программное обеспечение обычно используется пчеловодами, занимающимися сохранением исчезающего подвида Apis mellifera mellifera в Северной Европе [14]. Однако, используя ограниченное число признаков, CBeeWing не использует все преимущества информационного содержания, которое несет форма крыла, что делает идентификацию менее точной. На другой стороне спектра находится очень интенсивный метод DAWINO (дискриминантный анализ с числовым выводом), который требует измерения 30 признаков переднего крыла, включающих углы жилок, длину жилок и индексы [5].

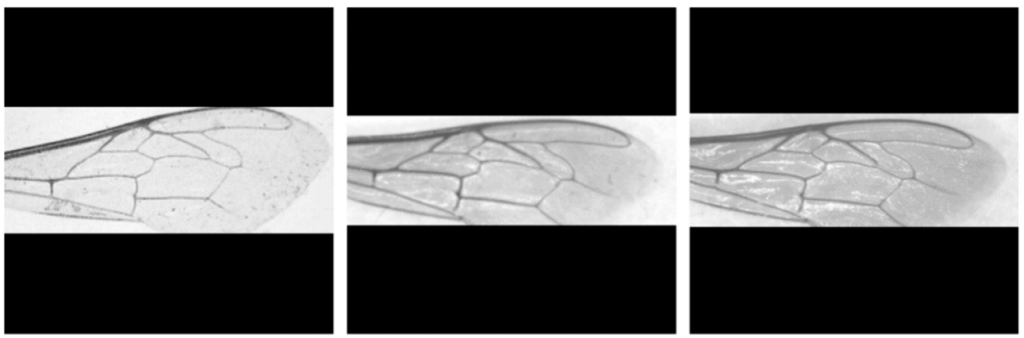

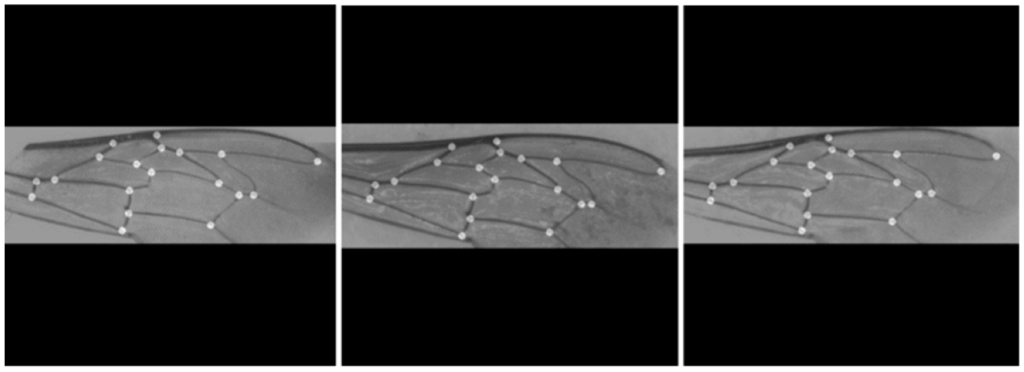

Анализ формы крыла на основе геометрии крыла, получивший название геометрической морфометрии крыла, предлагает интересную альтернативу для идентификации медоносной пчелы [5,10]. Геометрическая морфометрия крыла широко используется в таксономии насекомых в целом и оказалась особенно полезной для идентификации видов пчел [15,16,17,18,19], а также родов и подвидов медоносных пчел для широкого круга целей [6,8,11,12,20,21,22,23,24,25]. При использовании этого метода изменения формы крыла фиксируются по 19 точкам данных, известным как ориентиры, полученным из соединений вен, аннотированных на изображениях (рис. 1a,b). Учитывая, что расположение 19 ориентиров зависит от подвида, отклонения в позиционных координатах могут быть использованы для идентификации медоносной пчелы (рис. 1c,d). Большинство из 19 ориентиров также используются для расчета длины и углов всех вен как в классической морфометрии, так и в методе DAWINO [5]. Насколько нам известно, единственная общедоступная система для идентификации медоносных пчел по геометрической морфометрии крыла реализована в программе IdentiFly [26]. Проблема заключается в том, что IdentiFly — это полуавтоматическое программное обеспечение, требующее нескольких шагов для классификации крыльев, часто включающее ручную коррекцию аннотаций ориентиров, что делает его очень сложным для рутинного использования маточниками или пчеловодами.

Последние достижения в классификации медоносных пчел связаны с применением искусственного интеллекта с помощью методов машинного обучения [9]. Де Нарт и его коллеги [9] в основу своего метода классификации положили все крыло и использовали конволюционные нейронные сети (CNN) для разработки сквозного решения для разрешения изображений. К сожалению, этот новый инструмент ограничен классификацией только семи подвидов медоносных пчел, и он не был доступен для использования научным или пчеловодческим сообществом.

В глобальном мире сохранение генетической целостности местных подвидов медоносной пчелы становится все более сложной задачей. В этом контексте важно, чтобы специалисты по разведению маток, участвующие в программах по сохранению медоносных пчел, имели в своем распоряжении инструменты для идентификации колоний. Хотя молекулярные инструменты предлагают наиболее точное решение для идентификации подвидов [27,28], они не по карману большинству заводчиков маток, и в этом случае морфометрия становится единственным вариантом. Здесь мы восполнили пробел в геометрической морфометрической идентификации медоносных пчел, разработав полностью автоматизированное программное обеспечение, которое просто в использовании и свободно доступно как веб-сервис. Для этого мы применили методы машинного обучения для (i) обнаружения крыльев с помощью CNN, (ii) сегментирования ориентиров с помощью U-Net и (iii) классификации моделей с помощью машины опорных векторов (SVM). Используя этот многоэтапный подход, мы решили три основных вопроса: (i) Может ли детектор крыльев на основе CNN обрабатывать изображения с несколькими крыльями различной ориентации, обеспечивая однородность формы крыльев на входе сегментатора ориентиров? (ii) Способна ли U-Net извлекать таксономически информативные признаки из венчика крыла с высоким уровнем точности, что необходимо для точной классификации подвидов? (iii) Насколько эффективно SVM обобщает тонкие различия между близкородственными подвидами медоносной пчелы и, следовательно, обеспечивает точную классификацию?

2.Материалы и методы

2.1. Моделирование решения

На рисунке 2 в четырех кадрах показана модуляция, использованная в данной работе для достижения окончательного решения. Левый верхний кадр показывает организацию наборов данных, которые использовались для обучения трех моделей машинного обучения: детектора крыльев, сегментатора ориентиров и классификатора крыльев. Эти модели были обучены с использованием конфигураций, показанных на остальных кадрах, и получали данные из левого верхнего кадра. На левом нижнем кадре показана организация работы детектора крыльев, в котором изображения крыльев были входными данными, а положения ограничительных рамок (вокруг аннотированных вручную ориентиров) были целями для обучающих моделей CNN. На правом нижнем кадре показана организация сегментатора ориентиров, в которой на входы U-Net загружались изображения крыльев, а на выходы U-Net — соответствующие изображения ориентиров (маски). Наконец, правый верхний кадр показывает промежуточные элементы классификатора подвидов. На этом этапе обучения ранее аннотированные ориентиры (правый нижний кадр) были обработаны (PCA-сортировка-прокрусты) для обеспечения их геометрической стабилизации перед вводом в SVM-классификатор. В выводах SVM использовалась кодировка One-Hot, чтобы представить крылья различных подвидов.

2.2. Наборы данных изображений

Для обучения системы, разработанной в данном исследовании, были использованы два набора изображений. Набор данных 1 включал 5770 изображений правого переднего крыла рабочих медоносных пчел. Крылья были сфотографированы с креплений на микроскопических предметных стеклах (~10 крыльев на одно стекло) с помощью стереомикроскопа, соединенного с цифровой камерой с разрешением 1000 пикселей на сантиметр. Эти изображения были вручную аннотированы для 19 ориентиров одним оператором в соответствии с порядком расположения, представленным на рисунке 1a. Из 5770 изображений 3518 были собраны из иберийских колоний Apis mellifera iberiensis, идентифицированных по генетическим данным [25,29], а 2252 были собраны из азорейских колоний смешанного происхождения [25]. Набор данных 1 был аннотирован для популяционного анализа, проведенного Феррейрой и коллегами [25].

Набор данных 2 включал 1864 изображения правого переднего крыла рабочих медоносных пчел, полученных из Морфометрического банка данных пчел в Оберурселе, Германия, где хранятся оригинальные образцы, использованные Ф. Раттнером [1] в его основополагающей таксономической работе. Эти изображения были получены с монтировок на микроскопических предметных стеклах с помощью стереомикроскопа, соединенного с цифровой камерой с разрешением 650 пикселей на сантиметр. Набор данных 2 включал крылья, принадлежащие 26 подвидам, отобранным из всего ареала A. mellifera. Количество крыльев у каждого подвида варьировалось между четырьмя эволюционными линиями и подвидами. В частности, африканская линия (А) включала 116 A. m. adansonii, 30 A. m. capensis, 60 A. m. intermissa, 70 A. m. lamarckii, 55 A. m. litorea, 10 A. m. major, 80 A. m. monticola, 50 A. m. ruttneri, 20 A. m. sahariensis, 140 A. m. scutellata, 70 A. m. unicolor и 133 изображения крыльев A. m. jemenitica. Восточноевропейская линия (С) включала 150 изображений крыльев A. m. carnica, 90 A. m. cecropia, 110 A. m. ligustica, 20 A. m. macedonica и 10 A. m. siciliana. Западноевропейская линия (M) включала 20 изображений крыльев A. m. iberiensis и 140 изображений крыльев A. m. mellifera. Наконец, восточная линия (O) включала 50 изображений крыльев A. m. adami, 50 A. m. anatoliaca, 60 A. m. armeniaca, 120 A. m. caucasia, 40 A. m. cypria, 80 A. m. meda и 90 A. m. syriaca.

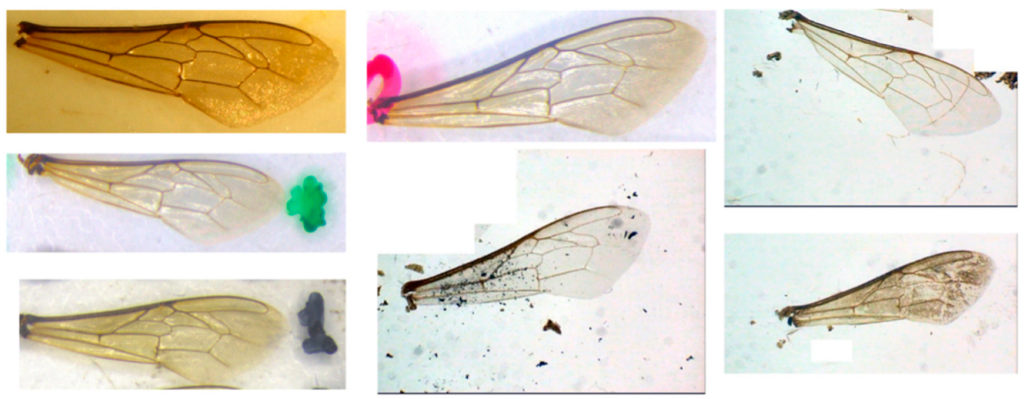

В отличие от высокого качества большинства изображений в наборе данных 1 (пример на рис. 1a), набор данных 2 содержал множество изображений с визуальными артефактами, шумом, изменениями позы, изменениями освещения и зеркальными отражениями света (примеры на рис. 3), что показывает сложность обобщения решения для надежной системы классификации. Кроме того, большинство изображений в обоих наборах данных содержали более одного крыла.

Эти два набора данных были объединены, а затем разделены на три подмножества в соответствии со следующими соотношениями: 80% для обучающего подмножества, 10% для проверочного подмножества и 10% для тестового подмножества. Эти три новых набора данных были созданы случайным образом из исходного объединенного набора данных. Учебный набор данных использовался для процесса обучения, валидационный набор данных использовался для настройки параметров моделей машинного обучения, а тестовый набор данных использовался для оценки окончательной функциональной производительности моделей машинного обучения.

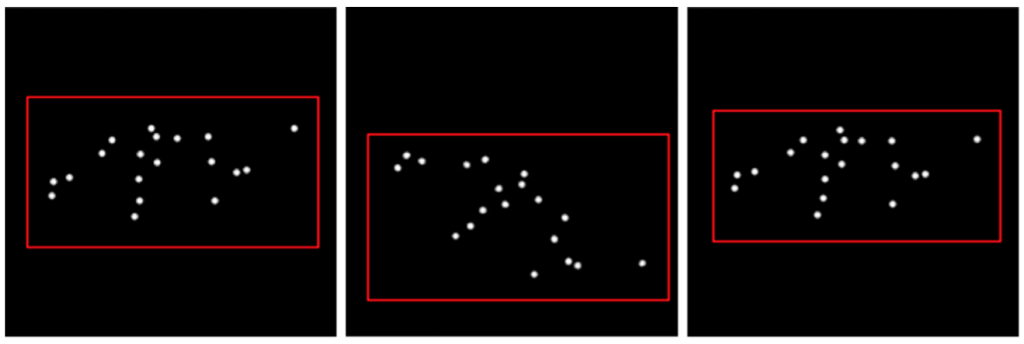

2.2.1. Маски

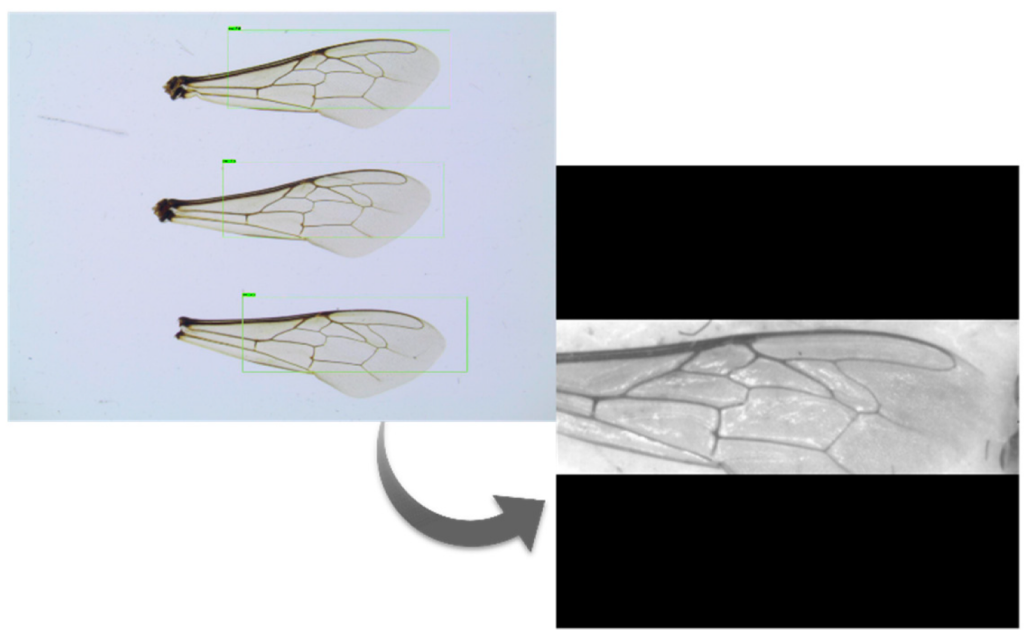

Маски размером с входные изображения были созданы алгоритмом на основе отмеченных вручную ориентиров из набора данных 1, при этом пиксели, образующие ориентиры, обозначались белым цветом, а фон — черным. Эти маски были целью нейронной сети U-Net [30]. На рисунке 4 приведены примеры выходных масок, созданных для обучения U-Net.

2.2.2. Расширение данных

Набор данных 2 был значительно меньше набора данных 1 и состоял из множества изображений, представляющих большой спектр визуальных вариаций (Рисунок 3), что контрастировало с высоким качеством изображений набора данных 1 (Рисунок 1a). Чтобы решить проблему несбалансированных наборов данных, набор данных 2 был искусственно расширен. Использование подхода к расширению данных [31] позволило создать большую базу данных для повышения точности автоматического сегментатора ориентиров. Для решения проблемы вариативности изображений были смоделированы специфические визуальные особенности, включая пыль, шум и резкие изменения угла (рис. 5).

2.3. Обработка и анализ изображений крыльев

Обработка и анализ изображений крыльев включает в себя три основных этапа: предварительную обработку, выделение ориентиров и классификацию (рис. 6). Система должна быть способна обрабатывать различные переменные изображения, такие как поза крыла, размер изображения и несколько крыльев на одном изображении.

2.3.1. Предварительная обработка

Предварительная обработка включает в себя несколько этапов, необходимых для обработки изображений для последующего обнаружения 19 ориентиров. Эти этапы включали применение фильтров, обнаружение крыльев, обрезку крыльев и нормализацию размера крыльев (рис. 6). После открытия изображений были применены два фильтра: фильтр CLHAE (Contrast Limited Adaptive Histogram Equalization) [32] для выделения важных особенностей изображения и фильтр Гаусса для удаления шума. Размер изображений был изменен до статического значения, и был использован детектор объектов на основе CNN [33], способный распознать существование каждого крыла на изображении. Такой подход позволил выполнить обрезку изображения нормализованным образом (рис. 7). Было протестировано несколько моделей детекторов объектов, включая SSD MobileNet v1 FPN coco [34], Faster R-CNN NAS [35], Faster R-CNN Inception Resnet v2 Atrous Coco [36] и YoloV3 [37].

Ни в одном из наборов данных не было аннотированных границ крыльев. Тем не менее, можно было вывести ограничительные рамки, используя координаты ориентиров из обучающего набора данных (рис. 8). Перед обучением распознаванию крыльев целевые ориентиры использовались для очерчивания области крыльев, а затем по периферийным ориентирам определялись ограничительные рамки. Пространственное поле вокруг ориентиров гарантировало, что они попадут внутрь ограничительной рамки.

2.3.2. Обнаружение ориентиров

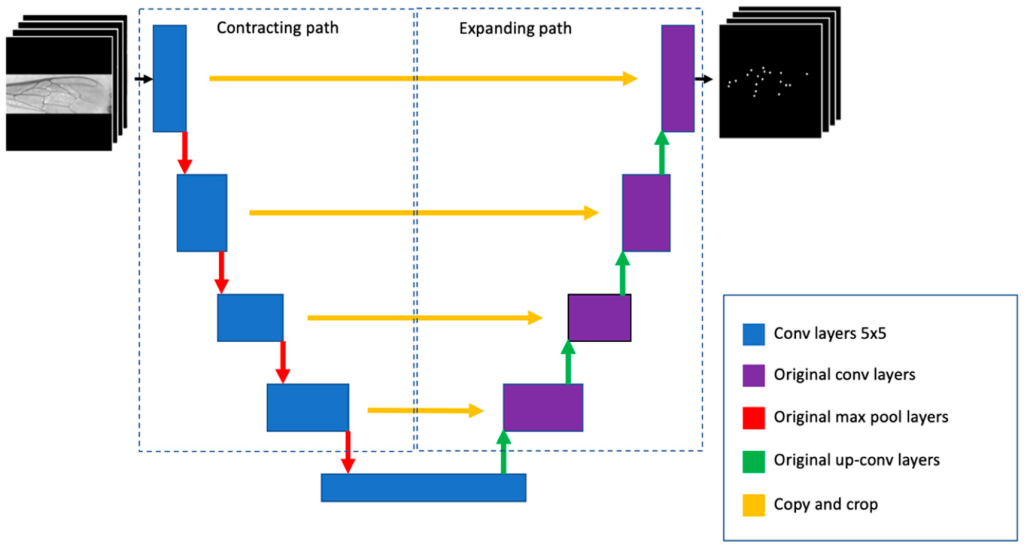

Обнаружение ориентиров состоит из нескольких этапов, включая реализацию детектора ориентиров, обнаружение блобов, настройку угла маски, извлечение и сортировку ориентиров (рис. 6). Детектор U-Net оказался более точным в сегментации 19 ориентиров, чем классификационный CNN и классические подходы (например, адаптивная бинаризация), доступные в библиотеке OpenCV [38]. Архитектура U-сети состоит из сужающегося пути для захвата контекста и симметричного расширяющегося пути, который позволяет точно позиционировать ориентиры путем извлечения их центров масс (рис. 9). U-сеть была обучена с помощью графического процессора GTX1080ti и фреймворка глубокого обучения Keras [39].

Изображения для обучения U-Net были преобразованы в серую шкалу, поскольку искомые ориентиры не зависят от цвета. Это помогло сэкономить вычислительную память и уменьшить «проклятие размерности» нейронной модели. Поскольку изображения крыльев имели различия в позиционных углах, обрезанные изображения имели разный размер (рис. 8). Кроме того, размер входных данных U-Net должен был быть статичным (400 × 400 входных данных), а соотношение ширины и высоты изображения крыла не могло быть изменено, чтобы избежать деформации модели. Поэтому изображение крыла было наложено на черный фон, где горизонтальная ось изображения крыла была масштабирована до пределов этого черного слоя (рис. 10).

Во время обучения U-Net стало очевидно, что использование только одного пикселя для представления каждого ориентира не является подходящим решением. Поэтому, чтобы увеличить соотношение сигнал/шум, U-сеть получила небольшой круг (синтетический ориентир) для каждого ориентира, что усилило ориентир как целевой регион для U-сети. После обучения синтетические ориентиры, полученные U-сетью, сформировали регионы, показанные на рисунке 11. Как и ожидалось, эти области не являются идеальным кругом, в отличие от целевых масок U-Net, показанных на рисунке 4.

Когда U-сеть сегментирует 19 ориентиров, она не идентифицирует каждый из них дифференцированно. Это критическая проблема, поскольку классификатор может принять правильное решение только в том случае, если в процессе обработки сохраняется порядок расположения ориентиров, показанных на рис. 1b. Первый шаг для обеспечения стандартизированного выделения ориентиров был основан на анализе главных компонент [40], который определяет наибольший собственный вектор, дающий угол распределения ориентиров. Затем, вращение всей маски в соответствии с этим углом позволяет выровнять ориентиры по горизонтальной оси. Эта процедура упростила механизм извлечения ориентиров в стандартном порядке, поскольку их шаблоны можно сканировать в последовательной позе.

Затем из масок, созданных U-сетью, необходимо было извлечь центр масс обнаруженных областей ориентиров. Наиболее простым способом сделать это было вычисление центра сегментированных областей с помощью Blob Detector, реализованного в библиотеке OpenCV. Общее число ожидаемых ориентиров (19) использовалось для проверки сегментации; если это число не подтверждалось, процесс завершался неудачей. После обнаружения все 19 ориентиров были отсортированы в соответствии с их позиционным расположением (рис. 1б), чтобы обеспечить точную классификацию. Этот шаг был выполнен путем размещения 19 ориентиров в списке, отсортированном в порядке возрастания по оси x. После сортировки, если на оси x находились значения, которые были очень близки друг к другу (расстояние 5 пикселей), то для устранения сомнений использовалась ось Y. Такой подход обеспечивал стандартное позиционирование ориентиров. Такой подход обеспечил стандартный порядок расположения 19 ориентиров, представленный на рисунке 1b, который не совпадает с порядком, введенным вручную (рисунок 1a).

Точность позиционирования 19 ориентиров оценивалась путем сравнения шаблонов ориентиров, полученных из результатов работы U-Net, с аннотированными вручную ориентирами (рис. 1). Точность данного вычисленного ориентира рассчитывалась в пространстве Прокруста путем сравнения его с соответствующим наземным ориентиром. Евклидовы расстояния между парами ориентиров затем суммировались и нормировались. Максимальная точность 1 достигалась, когда сумма расстояний была равна нулю.

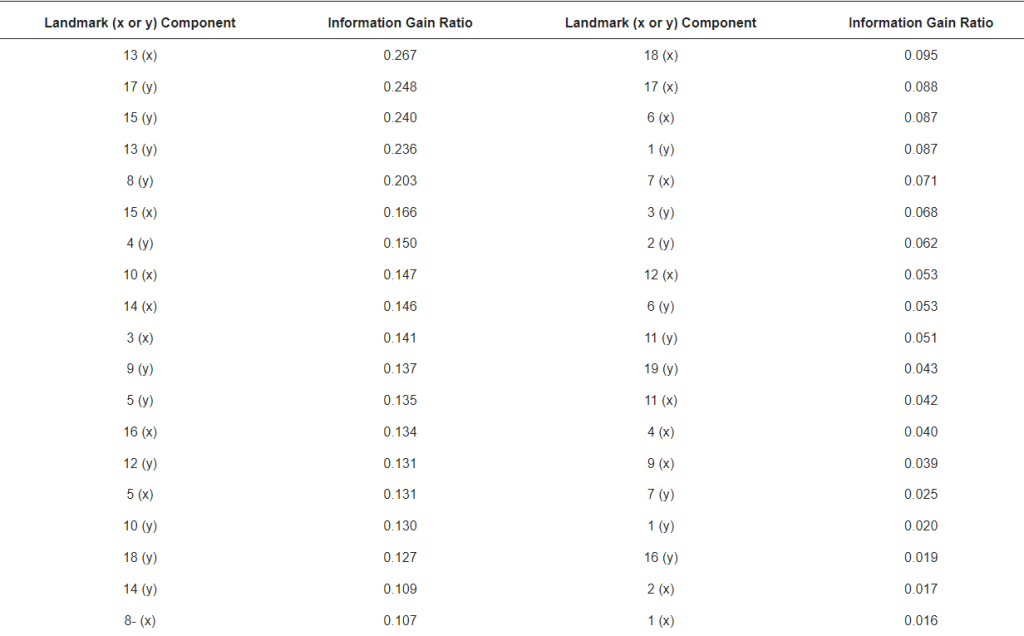

Информативность, которую несет каждый ориентир, рассчитывалась с помощью хорошо известного критерия коэффициента усиления информации [41]. Этот критерий измеряет неопределенность в том, как данные разделяются на основе конкретного признака. Значение коэффициента усиления информации рассчитывалось для каждого признака, что позволяло оценить их индивидуальное влияние на классификацию подвидов.

2.3.3. Классификация

На этапе классификации была проведена нормализация Прокруста (рис. 6), которая позволила игнорировать транспозицию, зеркальное отражение, поворот и масштаб различных знаковых паттернов [42]. Обобщенный анализ Прокруста (GPA) вычислял инвариантное среднее значение шаблонов ориентиров, полученных из обучающего набора данных. Линейная проекция нового шаблона ориентиров в инвариантном пространстве создает информационный паттерн, в котором выполняются правила инвариантности.

Классификация передних крыльев была выполнена с помощью машины опорных векторов (SVM) [43] с использованием библиотеки Scikit-Learn [44]. SVM обладает высокой способностью к обобщению и хорошо подходит для небольших наборов данных, как в случае с набором данных 2, использованным для обучения классификатора. Загрузка SVM геометрическими признаками, инвариантными к переводу, повороту и масштабу, была критически важна для достижения хороших результатов классификации. После классификации результаты были визуализированы и сохранены.

Результаты и обсуждение

3.1. Детектор крыльев

- Детектор крыльев необходим для извлечения нескольких крыльев из одного изображения и нормализации аспекта изображения, что позволяет стабильно загружать входы CNN. Несколько моделей детекторов объектов были обучены на наборе данных 1 с использованием трансферного обучения [45], что стабилизировало обучение с первых итераций. Критериями для выбора модели были точность и скорость, которые представлены для каждой протестированной модели в таблице 1.

| Модель | Coco mAP@0.5 | изображений в секунду |

| SSD MobileNet v1 FPN coco | 0.975 | 24 |

| Быстрее R-CNN NAS | 0.950 | 0.6 |

| Более быстрый R-CNN Inception Resnet v2 Atrous Coco | 0.950 | 1.8 |

| YoloV3 | 0.900 | 18 |

Хотя все обученные модели достигли уровня mAP > 0,9, модель SSD MobileNet v1 FPN coco [34] оказалась самой точной (0,975) и в то же время самой быстрой (24 изображения в секунду). Это был ожидаемый результат, поскольку MobileNet представляет собой более простую архитектуру, требующую меньшего количества изображений для обучения, чем другие модели. Более того, ее более простая архитектура может быть связана с ее способностью к обобщению, уменьшая «проклятие размерности». Эта способность к обобщению обеспечивает правильное определение крыльев даже при низком качестве изображений крыльев. Эта характеристика MobileNet будет иметь решающее значение для будущих пользователей разработанного здесь конвейера, поскольку анализируемые изображения, вероятно, будут иметь широкий спектр визуального разнообразия (например, зеркальные отражения, различный контраст) и артефактов (рис. 3).

Учитывая продемонстрированную превосходную производительность, MobileNet была выбрана для окончательной реализации системы. Этот детектор крыльев на основе CNN оказался важным для обеспечения однородности формы крыльев на входе в U-сеть, позволяя выделять несколько крыльев из одного изображения, даже если они имеют разную ориентацию.

3.2. Размер синтетических ориентиров для обучения

Размер синтетических ориентиров, обозначаемых как круги, напрямую влиял на эффективность U-сети на этапе обучения. Были рассмотрены круги с радиусом от одного до пяти пикселей. Наиболее подходящими оказались круги с радиусом три и четыре пикселя, причем последний вариант оказался лучше первого (табл. 2). Круги с радиусом менее трех пикселей были слишком малы и практически игнорировались нейронной сетью. С другой стороны, окружности с радиусом более четырех пикселей были слишком большими, что снижало точность позиционирования обнаруженных точек. Более того, в некоторых случаях большой размер радиуса приводил к слиянию различных областей ориентиров в одну, что препятствовало обнаружению всех 19 ориентиров.

| Радиус | измененные изображения | пыль | ядро | вес | Точность (%) | |

| 1 | 2 | No | No | 3 × 3 | No | 68.1 |

| 2 | 3 | No | No | 3 × 3 | No | 70.4 |

| 3 | 3 | Yes | No | 3 × 3 | No | 76.3 |

| 4 | 3 | Yes | No | 5 × 5 | No | 78.7 |

| 5 | 3 | Yes | Yes | 5 × 5 | No | 81.9 |

| 6 | 3 | Yes | Yes | 5 × 5 | Yes | 88.2 |

| 7 | 4 | Yes | Yes | 5 × 5 | Yes | 91.8 |

| 8 | 4 | Yes | Yes | 7 × 7 | Yes | 83.1 |

3.3. Оптимизация U-сети

U-сеть оказалась важным решением для обнаружения 19 ориентиров. Хотя мы пробовали классические детекторы объектов (например, Faster R-CNN, YoloV3), они оказались неспособны обеспечить хорошую точность в определении правильного положения ориентиров. Кроме того, как сегментатор, U-Net была разработана для составления пиксельно-ориентированных аннотаций, и эта точность хорошо подходила для нужд нашей системы.

Для улучшения функциональных характеристик U-Net было внесено несколько изменений в параметры. В оригинальной реализации U-Net используются ядра сверточного слоя размером 3 × 3 элемента, но в той версии больше внимания уделялось обнаружению краев [30]. Были протестированы ядра размером 3 × 3, 5 × 5 и 7 × 7. Ядра большего размера могли дать лучшие результаты благодаря более широкому взгляду на контекст ориентиров. Наилучшее качество сегментации было получено при размере 5 × 5 (табл. 2). Хотя в U-сеть не было добавлено новых слоев, изменение размера ядер оказало существенное влияние на память и скорость работы. Например, увеличение ядра с 3 × 3 до 5 × 5 сделало работу нейронной сети в три раза медленнее.

Результаты обучения U-сети были дополнительно оптимизированы путем применения различных подходов, включая (i) раннюю остановку [46], (ii) сокращение на плато [39] и (iii) функцию потери веса. Ранняя остановка прекращает обучение модели, когда потери при валидации начинают расти по сравнению с предыдущими итерациями обучения. Прерывая процесс вскоре после сходимости модели (состояние обобщения), можно избежать переоценки. Сокращение на плато снижает скорость обучения, когда показатель потерь перестает улучшаться. Применение этих двух подходов позволило добиться лучшего уровня сходимости и сегментации ориентиров. Функция потери веса, которая позволяет дифференцировать важность различных классов обучения, была реализована для выделения ориентиров относительно фона. Для иллюстрации проблемы изображение размером 400 × 400 имеет 160 000 пикселей и содержит 19 окружностей с радиусом четыре пикселя. Таким образом, только 955 из этих пикселей представляют собой ориентиры, подлежащие сегментации, что составляет <1% от общего числа пикселей. Соответственно, взвешивание двух классов с помощью функции потери веса имело решающее значение для достижения успеха сегментации. Было протестировано несколько конфигураций весов. Та, которая дала наилучшие результаты, сохранила вес класса фона равным единице и увеличила на 50 вес класса ориентиров.

3.4. Оценка сегментации ориентиров

В этом разделе параметризация и результаты, которые дают подходящее обобщение для сегментации ориентиров, анализируются с точки зрения (i) возможностей сегментации U-сети (обеспечение обнаружения 19 ориентиров), (ii) точности позиционирования 19 ориентиров и (iii) устойчивости обработки к пыли и шуму изображения.

В таблице 2 показана способность U-сети точно определять 19 ориентиров, используя несколько конфигураций в наборе данных для проверки. Радиус представляет собой радиус в пикселях ориентиров, использованных во время обучения. Измененные изображения показывают, были ли изображения повернуты или смещены в процессе увеличения данных в обучающем наборе данных. Пыль соответствует артефактам и шуму, искусственно добавленным к изображениям. Ядро соответствует размеру ядра U-Net. Веса представляют собой использование весовой функции потерь во время обучения. Точность указывает на успешность модели U-Net в обнаружении всех 19 ориентиров. Сводная информация о более широкой сетке комбинаций параметров представлена в таблице 2. Линии 1 и 2 показывают улучшение работы U-Net при увеличении радиуса окружности с 2 до 3. Линии 2 и 3 показывают улучшение в результате увеличения данных за счет аффинных геометрических преобразований (Altered Images). Линии 3 и 4 показывают преимущество использования ядра размером 5 × 5 по сравнению с 3 × 3. Улучшение, достигнутое в результате добавления шума, видно при сравнении линий 4 и 5. Сравнение строк 5 и 6 подчеркивает преимущество использования функции потери веса для обучения U-сети. Строки 6, 7 и 8 показывают, что радиус размера 4 превосходит радиус размера 3, а размер ядра 5 × 5 превосходит 7 × 7. При комбинировании лучших параметров точность сегментации ориентиров достигает 91,8%.

Модель U-Net научилась справляться с проблемами пыли и изменения угла, как показано для нескольких примеров на рис. 12a,b. Однако, когда изображения были чрезмерно испорчены визуальными артефактами, некоторые ориентиры оставались необнаруженными (рис. 12c). Помимо искажения обнаружения ориентиров, артефакты на изображении могут также создавать ложные срабатывания.

Точность позиционирования 19 вычисленных ориентиров оценивалась на тестовом наборе данных путем сравнения сгенерированных U-Net ориентиров с аннотированными вручную ориентирами (рис. 1). Получение высокоточного сегментатора ориентиров имеет решающее значение для классификации медоносных пчел при использовании геометрической морфометрии крыла. Это связано с тем, что расположение 19 ориентиров зависит от подвида, как показано на рисунке 1c,d для двух генетически близких подвидов [5], и любая ошибка позиционирования повлияет на точность классификации. Как показано в Таблице 3, точность варьировалась в зависимости от ориентиров, причем наименьшее значение было получено для ориентира 9 (0,900), а наибольшее — для ориентира 19 (0,975). Любопытно, что ориентир 19 является единственным, расположенным вне узла вены. Средняя точность, полученная для 19 вычисленных ориентиров, составила 0,943 ± 0,020.

| Ориентир | Точность | Ориентир | Точность |

| 1 | 0.968 | 11 | 0.924 |

| 2 | 0.970 | 12 | 0.926 |

| 3 | 0.963 | 13 | 0.937 |

| 4 | 0.954 | 14 | 0.945 |

| 5 | 0.911 | 15 | 0.933 |

| 6 | 0.932 | 16 | 0.931 |

| 7 | 0.939 | 17 | 0.958 |

| 8 | 0.950 | 18 | 0.962 |

| 9 | 0.900 | 19 | 0.975 |

| 10 | 0.937 | Среднее ± SD | 0.943 ± 0.020 |

Хотя все 19 ориентиров используются классификатором подвидов, информативность каждого из них различна. В таблице 4 показан коэффициент усиления информации, полученный для каждого входного признака x и y, связанного с 19 координатами ориентиров. Наиболее важными признаками (коэффициент усиления информации > 0,2) для классификации подвидов были 13-x, 17-y, 15-y, 13-y и 8-y, которые показали точность от 0,933 (ориентир 15) до 0,958 (ориентир 17; Таблица 3). Интересно, что эти четыре ориентира задействованы в расчетах кубитального индекса, индекса хантеля и угла дисковидного сдвига, которые используются многими селекционерами, занимающимися сохранением A. m. mellifera [14]. Этот вывод говорит о том, что конвейер использует с хорошей точностью признаки, которые хорошо известны как коррелирующие с подвидом. Более того, использование крыловых ориентиров в классификации медоносных пчел позволяет использовать очень положительный критерий для автоматического исключения изображений, поскольку классификация прерывается, если количество извлеченных ориентиров отличается от 19.

В целом, проведенные здесь эссе с использованием сложных изображений из набора данных 2 и изображений из внешних наборов данных (данные не показаны) показали высокую способность U-сети к обобщению при обнаружении ориентиров. Модель U-Net была способна не только обнаруживать каждый ориентир по отдельности, но и связывать ориентиры в единый паттерн, позволяя делать выводы о пропущенных ориентирах. Кроме того, U-Net продемонстрировала способность к точности и устойчивость при работе с новыми и визуально поврежденными изображениями.

Данное исследование дает новое понимание в области машинного обучения, предлагая альтернативное решение для задач, требующих аннотации ориентиров с высоким уровнем точности (например, опорные точки на аэроснимках, точки на лице, используемые для биометрического распознавания, маркеры на суставах тела, используемые для регистрации движения, анатомические ориентиры на медицинских изображениях, миниатюры отпечатков пальцев для распознавания лиц). Насколько нам известно, наш подход является уникальным в использовании U-сети для сегментации ориентиров. Примечательно, что U-Net позволила провести точную и надежную (относительно шума) сегментацию при использовании ядра 5 × 5 и масок ориентиров с радиусом 4 пикселя. Более того, использование весовой функции стоимости оказалось важным для выделения ориентиров относительно фона, что еще больше способствовало успеху окончательного решения.

3.5. Классификация

Классификатор получает признаки изображения, уже обработанные и упрощенные на предыдущих этапах конвейера (рис. 6). Например, U-Net переводит изображение крыла в 19 стабильных точек данных, а метод Прокруста обеспечивает позиционную независимость (перевод, масштаб, поворот), чтобы избежать обучающего набора данных с этими вариациями и позволить в будущем классифицировать изображения с различными вариациями.

Изображения были классифицированы с помощью SVM [43], модели, которая не требует большой гиперпараметризации, что упрощает этап обучения. Набор данных для проверки использовался для поиска конфигурации SVM, которая давала наиболее точную классификацию. Коэффициент C SVM составил 30, значение гаммы — 0,17, а лучшим ядром была радиальная базовая функция (RBF). Входные данные модели состояли из 38 значений (координаты ориентиров x, y), нормализованных методом Прокруста. Выход модели кодировал классифицируемый подвид.

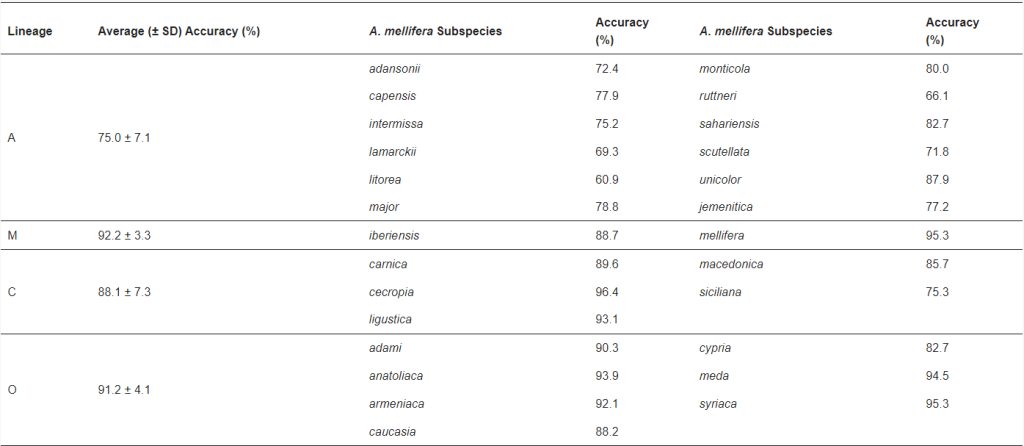

Окончательная конфигурация SVM смогла классифицировать передние крылья с 86,6% ± 6,9 средней точностью (±SD) среди 26 подвидов, представленных в тестовом наборе данных (Таблица 5), несмотря на относительно небольшое количество изображений, использованных для обучения классификации, и низкое качество многих из них (Рисунок 3). Nawrocka и коллеги [8] обнаружили аналогичную среднюю точность (88,4%) для аналогичного набора данных, аннотированных вручную (25 вместо 26 подвидов коллекции Oberursel), что еще раз подтверждает эффективность разработанной здесь системы. Эти авторы [8] также использовали метод геометрической морфометрии, хотя они классифицировали 25 подвидов с помощью линейного анализа канонических переменных в отличие от нелинейного подхода SVM. В другом исследовании Да Сильва и коллеги [7] использовали аннотированные вручную ориентиры на изображениях крыльев Oberursel для сравнения семи различных классификаторов, включая SVM. Неожиданно авторы сообщили о низкой производительности классификатора SVM (60,04%) по сравнению с данным исследованием, а лучший классификатор, Naïve Bayes, достиг только 65,15% точности при перекрестной валидации.

Окончательная конфигурация SVM смогла классифицировать передние крылья со средней точностью 86,6% ± 6,9 (±SD) среди 26 подвидов, представленных в тестовом наборе данных (Таблица 5), несмотря на относительно небольшое количество изображений, использованных для обучения классификации, и низкое качество многих из них (Рисунок 3). Nawrocka и коллеги [8] обнаружили аналогичную среднюю точность (88,4%) для аналогичного набора данных, аннотированных вручную (25 вместо 26 подвидов коллекции Oberursel), что еще раз подтверждает эффективность разработанной здесь системы. Эти авторы [8] также использовали метод геометрической морфометрии, хотя они классифицировали 25 подвидов с помощью линейного анализа канонических переменных в отличие от нелинейного подхода SVM. В другом исследовании Да Сильва и коллеги [7] использовали аннотированные вручную ориентиры на изображениях крыльев Oberursel для сравнения семи различных классификаторов, включая SVM. Неожиданно авторы сообщили о низкой производительности классификатора SVM (60,04%) по сравнению с данным исследованием, а лучший классификатор, Naïve Bayes, достиг только 65,15% точности при перекрестной валидации.

На уровне подвидов самая низкая точность наблюдалась для африканского A. m. litorea (60,9%), а самая высокая — для восточноевропейского A. m. cecropia (96,4%; Таблица 5). На уровне родословной самая низкая средняя точность наблюдалась для африканской (75,0%) и самая высокая для западноевропейской (92,2%; Таблица 5). Более низкая производительность классификатора для африканских подвидов согласуется с результатами [8] и объясняется более тесной морфологической близостью между подвидами из центральной и южной Африки. Соответственно, когда подвиды африканского происхождения были исключены из анализа, точность классификации возросла до 90,5% ± 1,7.

Производительность системы была еще более улучшена (точность 95,8%; Таблица 6) путем обучения другой модели только с пятью подвидами, выбранными по их коммерческой ценности (A. m. ligustica, A. m. carnica и A. m. caucasia) или природоохранному статусу (A. m. mellifera и родственный ей A. m. iberiensis) [47]. За исключением A. m. iberiensis, остальные четыре подвида были наиболее полно представлены в наборе данных 2, использованном для обучения классификации, причем A. m. carnica имеет наибольшее количество изображений крыльев (n = 150). Хотя исключение подвидов с африканским происхождением привело к повышению точности классификации (данное исследование и [8]), возможно, что улучшенная производительность, достигнутая моделью из пяти подвидов, также связана с большим размером выборки, использованной во время обучения. Несмотря на то, что наша система напрямую не сопоставима с нашей, сквозное решение, разработанное на основе всего крыла (в отличие от ориентиров) Де Нартом и коллегами [9], достигло точности 99% при кросс-валидации на гораздо большем (n = 9887) собственном наборе данных изображений крыльев, представляющем один гибрид и семь подвидов (A. m. ligustica, A. m. carnica, A. m. caucasia, A. m. anatoliaca, A. m. siciliana, A. m. iberiensis, A. m. mellifera) с использованием CNN.

| Подвид A. mellifera | Точность (%) |

| carnica | 98.9 |

| caucasia | 97.7 |

| iberiensis | 91.1 |

| ligustica | 96.4 |

| mellifera | 95.0 |

| Среднее ± SD | 95,8 ± 2,7 |

Обучение системы на большем количестве изображений крыльев каждого подвида может привести к более точной классификации. Однако эта задача может быть решена только с использованием изображений крыльев, полученных от новых экземпляров, собранных за пределами коллекции Оберурсель, как это было сделано Де Нартом и коллегами [9]. Проблема заключается в том, что эта работа предполагает идентификацию образцов по полному набору морфологических признаков, что требует много времени и экспертных знаний, которые не всегда доступны [5]. Более того, разработанный здесь классификационный конвейер был основан на явном выборе обучения системы на оригинальной коллекции крыльев, использованной Раттнером [1] для разграничения подвидов A. mellifera, несмотря на малое количество изображений крыльев и их часто низкое качество. Тем не менее, при необходимости система может быть обучена на новых примерах для улучшения классификации на всех типах изображений крыльев.

3.6. Анализ вычислительных затрат

Окончательная реализация системы, использующая CNN MobileNet, U-Net и SVM, показала хорошую скорость работы, потребовав 14 с для обработки 10 изображений, что является минимальным количеством, рекомендованным для идентификации на уровне колонии [5]. Вычислительная машина была основана на шестиядерном процессоре i5-9400@2.9 ГГц и 16 Гбайт оперативной памяти. Поскольку реализованное решение основано на потоках, общая скорость работы может быть увеличена за счет использования процессора с большим количеством ядер. Тактовая частота процессора также напрямую влияет на скоростные характеристики, поскольку для основной обработки требуются математические векторные операции, которые коррелируют со скоростью векторных инструкций. Фреймворк глубокого обучения позволяет запускать код на GPU для достижения общей скорости примерно в 15 раз по сравнению с CPU.

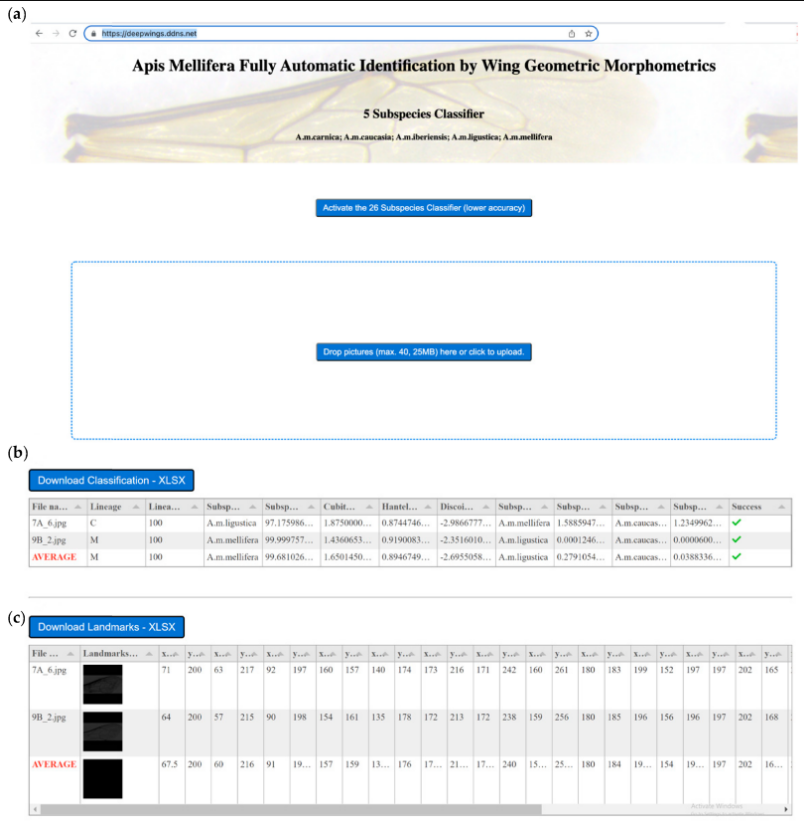

3.7. DeepWings© как веб-сервис

Разработанный здесь конвейер для идентификации подвидов медоносной пчелы был зарегистрирован как программное обеспечение под названием DeepWings© (Registo de obra n.° 3214/2019, Inspeção-Geral das Atividades Culturais). DeepWings© реализован как бесплатный веб-сервис, доступный по адресу https://deepwings.ddns.net, доступ получен 26 апреля 2022 года. Для программирования веб-сервиса использовался фреймворк Flask, который был построен с использованием параллельного программирования на основе потоков.

DeepWings© — это удобное программное обеспечение, которое требует только перетаскивания изображений крыльев в зону сброса файлов (рис. 13a). После обработки изображений на веб-странице строится таблица, содержащая вероятности трех ведущих подвидов (рис. 13b). Помимо классификации, DeepWings© вычисляет несколько геометрических параметров крыла и координаты ориентиров (Рисунок 13c). Вероятность классификации, геометрические параметры (кубитальный индекс, индекс хантеля, угол дисковидного сдвига) и координаты ориентиров могут быть загружены в виде файлов excel, что облегчает хранение данных для дальнейшего анализа или альтернативных приложений. Например, координаты ориентиров могут быть использованы непосредственно другими программами идентификации, такими как MorphoJ [48] или IdentiFly [26], или для расчета углов и длин, необходимых для других методов, таких как DAWINO или классическая морфометрия крыла [5]. Поэтому DeepWings© можно использовать в сочетании с измерениями других признаков тела (например, волосистости, пигментации, длины хоботка) для целей, требующих более интенсивных методов, таких как идентификация новых подвидов [2,3,4,5]. Однако, что более важно, у пчеловодов и заводчиков маток теперь есть удобный инструмент для идентификации своих колоний в природоохранных или коммерческих целях.

Все больше признается, что устойчивое пчеловодство требует использования местных подвидов, поскольку они лучше адаптированы к местным условиям и демонстрируют более высокую производительность по сравнению с экзотическими подвидами [49]. Проблема заключается в том, что генетическая целостность многих подвидов медоносных пчел находится под угрозой после многих поколений импорта экзотических маток [47]. A. m. mellifera является лучшим примером такой ситуации, поскольку на больших участках своего родного распространения этот подвид сильно интрогрессирован или даже находится на грани исчезновения. Это привело к росту спроса на местные подвиды, особенно на A. m. mellifera, и, следовательно, на инструменты идентификации, которые могут быть использованы для сертификации происхождения маток. Такая сертификация необходима пчеловодам для (i) перемещения своих колоний в природоохранные зоны, (ii) мониторинга эффективности изолированных брачных станций и (iii) получения субсидий в соответствии с местным или европейским законодательством. Кроме того, пчеловоды могут повысить рыночную стоимость своего поголовья путем сертификации происхождения маток. Высокоточная идентификация подвидов подразумевает измерение 36 морфологических признаков [5] или генотипирование геномных молекулярных маркеров [28]. Однако эти методы недоступны для большинства пчеловодов и заводчиков маток, так как первые слишком трудоемки и требуют много времени, а вторые все еще слишком дороги. DeepWings© предлагает альтернативное решение для вышеупомянутых приложений, которые часто не требуют уровня точности, обеспечиваемого этими морфологическими или молекулярными методами.

4.Выводы

Разработанное здесь программное обеспечение DeepWings© для идентификации медоносных пчел по геометрической морфометрии крыльев сочетает в себе CNN в качестве детектора крыльев, U-Net глубокого обучения в качестве сегментатора ориентиров и SVM в качестве классификатора подвидов. Это многоэтапное решение оказалось более подходящим, чем сквозное решение для нашей задачи, по трем основным причинам. Во-первых, используя модели низкой сложности (U-Net и SVM), можно было обучить систему на небольшой коллекции крыльев, использованной Раттнером [1] для определения подвидов медоносной пчелы. Во-вторых, это позволило нейронной модели искать признаки (ориентиры), которые используются стандартным методом классификации медоносных пчел по крыльям: геометрическая морфометрия. В-третьих, благодаря внедрению метода Прокруста между этапом обнаружения ориентиров и этапом классификации, классификатор может быть обучен с большей надежностью, поскольку не нужно изучать инварианты крыльев (перевод, поворот и масштаб). Несмотря на кажущуюся сложность, система показала хорошую скорость работы, потребовав 14 с для обработки 10 изображений, что является минимальным количеством, рекомендованным для идентификации на уровне колонии [5].

Хотя существует еще один инструмент геометрической морфометрии крыльев (IdentiFly) для классификации медоносных пчел, DeepWings© является первым, который делает это полностью автоматизированным способом. Научная новизна и наибольший вклад нашего решения в классификацию медоносных пчел связаны с возможностью DeepWings© сегментировать крылья на изображениях, содержащих различные артефакты, различное количество крыльев и крылья с различной ориентацией, а затем сегментировать ориентиры с высокой точностью.

Поскольку форма крыльев у разных подвидов немного отличается, особенно если они принадлежат к одной линии, очень важно было использовать сегментатор, который позволял бы с высокой точностью определять 19 ориентиров. Эта цель была достигнута благодаря использованию U-сети, которая показала хорошую производительность даже в условиях сильного шума на изображениях.

Использование SVM для классификации оказалось хорошим решением с подходящей обобщенностью, учитывая слабое разделение между подвидами (особенно африканскими) и малое количество изображений, доступных для обучения классификации (26 подвидов представлены всего 1864 изображениями). Несмотря на эти ограничения, точность классификации составила 86,6% для 26 подвидов и увеличилась до 95,8%, когда классификатор был обучен только на пяти подвидах. Более высокой точности можно было бы ожидать, если бы набор данных, использованный для обучения классификации, был больше. Однако, несмотря на малое количество изображений крыльев, содержащихся в коллекции Oberursel, и их часто низкое качество, мы однозначно выбрали для обучения нашей системы набор данных, который первоначально использовался Руттнером [1] для разграничения подвидов A. mellifera.

DeepWings© доступен в виде бесплатного программного обеспечения для использования в идентификации колоний в различных целях (например, для мониторинга изолированных брачных станций, отбора маток на природоохранных пасеках) пчеловодами, заводчиками маток и даже учеными. Помимо классификации, DeepWings© предоставляет координаты 19 ориентиров, которые могут быть обработаны другим программным обеспечением, что облегчает обмен данными между различными научными исследованиями и исследовательскими группами.

Ссылки

1.Ruttner, F. Biogeography and Taxonomy of Honeybees; Springer: Berlin/Heidelberg, Germany, 1988; p. 284.

[Google Scholar]

2.Sheppard, W.S.; Meixner, M.D. Apis mellifera pomonella, a new honey bee subspecies from Central Asia. Apidologie 2003, 34, 367–375.

[Google Scholar] [CrossRef][Green Version]

3.Meixner, M.D.; Leta, M.A.; Koeniger, N.; Fuchs, S. The honey bees of Ethiopia represent a new subspecies of Apis mellifera—Apis mellifera simensis n. ssp. Apidologie 2011, 42, 425–437.

[Google Scholar] [CrossRef]

4.Chen, C.; Liu, Z.G.; Pan, Q.; Chen, X.; Wang, H.H.; Guo, H.K.; Liu, S.D.; Lu, H.F.; Tian, S.L.; Li, R.Q.; et al. Genomic analyses reveal demographic history and temperate adaptation of the newly discovered honey bee subspecies Apis mellifera sinisxinyuan n. ssp. Mol. Biol. Evol. 2016, 33, 1337–1348.

[Google Scholar] [CrossRef] [PubMed][Green Version]

5.Meixner, M.D.; Pinto, M.A.; Bouga, M.; Kryger, P.; Ivanova, E.; Fuchs, S. Standard methods for characterising subspecies and ecotypes of Apis mellifera. J. Apic. Res. 2013, 52, 1–28.

[Google Scholar] [CrossRef]

6.Tofilski, A. DrawWing, a program for numerical description of insect wings. J. Insect Sci. 2004, 4, 17.

[Google Scholar] [CrossRef]

7.Da Silva, F.L.; Sella, M.L.G.; Francoy, T.M.; Costa, A.H.R. Evaluating classification and feature selection techniques for honeybee subspecies identification using wing images. Comput. Electron. Agric. 2015, 114, 68–77.

[Google Scholar] [CrossRef]

8.Nawrocka, A.; Kandemir, I.; Fuchs, S.; Tofilski, A. Computer software for identification of honey bee subspecies and evolutionary lineages. Apidologie 2018, 49, 172–184.

[Google Scholar] [CrossRef][Green Version]

9.De Nart, D.; Costa, C.; di Prisco, G.; Carpana, E. Image recognition using convolutional neural networks for classification of honey bee subspecies. Apidologie 2022, 53, 5.

[Google Scholar] [CrossRef]

10.Bookstein, F.L. Morphometric Tools for Landmark Data: Geometry and Biology; Cambridge University Press: Cambridge, UK, 1992.

[Google Scholar]

11.Francoy, T.M.; Wittmann, D.; Drauschke, M.; Muller, S.; Steinhage, V.; Bezerra-Laure, M.A.F.; De Jong, D.; Goncalves, L.S. Identification of Africanized honey bees through wing morphometrics: Two fast and efficient procedures. Apidologie 2008, 39, 488–494.

[Google Scholar] [CrossRef][Green Version]

12.Kandemir, I.; Ozkan, A.; Fuchs, S. Reevaluation of honeybee (Apis mellifera) microtaxonomy: A geometric morphometric approach. Apidologie 2011, 42, 618–627.

[Google Scholar] [CrossRef][Green Version]

13.Prabucki, J.S.; Samborski, J.; Chuda-Mickiewicz, B. The use of three taxonomic characters for race identification of Middle European bee. J. Apic. Sci. 2002, 46, 41–47.

[Google Scholar]

14.Bouga, M.; Alaux, C.; Bienkowska, M.; Buchler, R.; Carreck, N.L.; Cauia, E.; Chlebo, R.; Dahle, B.; Dall’Olio, R.; De la Rua, P.; et al. A review of methods for discrimination of honey bee populations as applied to European beekeeping. J. Apic. Res. 2011, 50, 51–84.

[Google Scholar] [CrossRef][Green Version]

15.Bonatti, V.; Simoes, Z.L.P.; Franco, F.F.; Francoy, T.M. Evidence of at least two evolutionary lineages in Melipona subnitida (Apidae, Meliponini) suggested by mtDNA variability and geometric morphometrics of forewings. Naturwissenschaften 2014, 101, 17–24.

[Google Scholar] [CrossRef] [PubMed]

16.Francoy, T.M.; Franco, F.D.; Roubik, D.W. Integrated landmark and outline-based morphometric methods efficiently distinguish species of Euglossa (Hymenoptera, Apidae, Euglossini). Apidologie 2012, 43, 609–617.

[Google Scholar] [CrossRef][Green Version]

17.Francoy, T.M.; Bonatti, V.; Viraktamath, S.; Rajankar, B.R. Wing morphometrics indicates the existence of two distinct phenotypic clusters within population of Tetragonula iridipennis (Apidae: Meliponini) from India. Insectes Sociaux 2016, 63, 109–115.

[Google Scholar] [CrossRef]

18.Costa, C.P.; Machado, C.A.S.; Santiago, W.M.S.; Dallacqua, R.P.; Garófalo, C.A.; Francoy, T.M. Biome variation, not distance between populations, explains morphological variability in the orchid bee Eulaema nigrita (Hymenoptera, Apidae, Euglossini). Apidologie 2020, 51, 984–996.

[Google Scholar] [CrossRef]

19.Rebelo, A.R.; Fagundes, J.M.G.; Digiampietri, L.A.; Francoy, T.M.; Biscaro, H.H. A fully automatic classification of bee species from wing images. Apidologie 2021, 52, 1060–1074.

[Google Scholar] [CrossRef]

20.Francoy, T.M.; Prado, P.R.R.; Gonçalves, L.S.; Costa, L.d.F.; Jong, D.D. Morphometric differences in a single wing cell can discriminate Apis mellifera racial types. Apidologie 2006, 37, 91–97.

[Google Scholar] [CrossRef][Green Version]

21.Evin, A.; Baylac, M.; Ruedi, M.; Mucedda, M.; Pons, J.-M. Taxonomy, skull diversity and evolution in a species complex of Myotis (Chiroptera: Vespertilionidae): A geometric morphometric appraisal. Biol. J. Linn. Soc. 2008, 95, 529–538. [Google Scholar] [CrossRef]

22.Tofilski, A. Using geometric morphometrics and standard morphometry to discriminate three honeybee subspecies. Apidologie 2008, 39, 558–563.

[Google Scholar] [CrossRef][Green Version]

23.Miguel, I.; Baylac, M.; Iriondo, M.; Manzano, C.; Garnery, L.; Estonba, A. Both geometric morphometric and microsatellite data consistently support the differentiation of the Apis mellifera M evolutionary branch. Apidologie 2011, 42, 150–161.

[Google Scholar] [CrossRef][Green Version]

24.Oleksa, A.; Tofilski, A. Wing geometric morphometrics and microsatellite analysis provide similar discrimination of honey bee subspecies. Apidologie 2015, 46, 49–60.

[Google Scholar] [CrossRef][Green Version]

25.Ferreira, H.; Henriques, D.; Neves, C.J.; Machado, C.A.S.; Azevedo, J.C.; Francoy, T.M.; Pinto, M.A. Historical and contemporaneous human-mediated processes left a strong genetic signature on honey bee populations from the Macaronesian archipelago of the Azores. Apidologie 2020, 51, 316–328.

[Google Scholar] [CrossRef][Green Version]

26.Tofilski, A. IdentiFly Software, Version 0.31. Available online: http://drawwing.org/identifly (accessed on 4 April 2022).

27.Henriques, D.; Browne, K.A.; Barnett, M.W.; Parejo, M.; Kryger, P.; Freeman, T.C.; Muñoz, I.; Garnery, L.; Highet, F.; Jonhston, J.S.; et al. High sample throughput genotyping for estimating C-lineage introgression in the dark honeybee: An accurate and cost-effective SNP-based tool. Sci. Rep. 2018, 8, 8552.

[Google Scholar] [CrossRef] [PubMed][Green Version]

28.Momeni, J.; Parejo, M.; Nielsen, R.O.; Langa, J.; Montes, I.; Papoutsis, L.; Farajzadeh, L.; Bendixen, C.; Căuia, E.; Charrière, J.-D.; et al. Authoritative subspecies diagnosis tool for European honey bees based on ancestry informative SNPs. BMC Genom. 2021, 22, 101.

[Google Scholar] [CrossRef]

29.Chavez-Galarza, J.; Henriques, D.; Johnston, J.S.; Carneiro, M.; Rufino, J.; Patton, J.C.; Pinto, M.A. Revisiting the Iberian honey bee (Apis mellifera iberiensis) contact zone: Maternal and genome-wide nuclear variations provide support for secondary contact from historical refugia. Mol. Ecol. 2015, 24, 2973–2992.

[Google Scholar] [CrossRef]

30.Ronneberger, O.; Fischer, P.; Brox, T. U-Net: Convolutional networks for biomedical image segmentation. In Lecture Notes in Computer Science; Springer International Publishing: Cham, Switzerland, 2015; Volume 9351, pp. 234–241. [Google Scholar] [CrossRef][Green Version]

31.Krizhevsky, A.; Sutskever, I.; Hinton, G.E. ImageNet classification with deep convolutional neural networks. In Proceedings of the 25th International Conference on Neural Information Processing Systems—Volume 1, Lake Tahoe, Nevada, 3–6 December 2012; pp. 1097–1105.

[Google Scholar]

32.Bradski, G.R.; Pisarevsky, V. Intel’s computer vision library: Applications in calibration, stereo, segmentation, tracking, gesture, face and object recognition. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR 2000), Hilton Head, SC, USA, 15 June 2000; pp. 796–797.

[Google Scholar]

33.LeCun, Y.; Bengio, Y.; Hinton, G. Deep learning. Nature 2015, 521, 436–444.

[Google Scholar] [CrossRef]

34.Howard, A.G.; Zhu, M.; Chen, B.; Kalenichenko, D.; Wang, W.; Weyand, T.; Andreetto, M.; Adam, H. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv 2017, arXiv:1704.04861.

[Google Scholar]

35.Ren, S.; He, K.; Girshick, R.; Sun, J. Faster R-CNN: Towards real-time object detection with region proposal networks. IEEE Trans. Pattern Anal. Mach. Intell. 2017, 39, 1137–1149.

[Google Scholar] [CrossRef][Green Version]

36.Szegedy, C.; Ioffe, S.; Vanhoucke, V.; Alemi, A.A. Inception-v4, Inception-ResNet and the impact of residual connections on learning. In Proceedings of the Thirty-First Aaai Conference on Artificial Intelligence, San Francisco, CA, USA, 4–9 February 2017; pp. 4278–4284.

[Google Scholar]

37.Redmon, J.; Farhadi, A. YOLOv3: An incremental improvement. arXiv 2018, arXiv:1804.02767.

[Google Scholar]

38.Kaehler, A.; Bradski, G.R. Learning OpenCV 3: Computer Vision in C++ with the OpenCV Library, 1st ed.; O’Reilly Media: Sebastopol, CA, USA, 2017; 990 p.

[Google Scholar]

39.Chollet, F. Keras: The Python Deep Learning Library; Astrophysics Source Code Library: Houghton, MI, USA, 2018; p. ascl:1806.1022.

[Google Scholar]

40.Mudrová, M.; Procházka, A. Principal component analysis in image processing. In Proceedings of the MATLAB Technical Computing Conference, Prague, Czech Republic, 4–8 July 2005.

[Google Scholar]

41.Quinlan, J.R. Simplifying decision trees. Int. J. Man-Mach. Stud. 1987, 27, 221–234.

[Google Scholar] [CrossRef][Green Version]

42.Gower, J.C. Generalized procrustes analysis. Psychometrika 1975, 40, 33–51.

[Google Scholar] [CrossRef]

43.Cortes, C.; Vapnik, V. Support-Vector Networks. Mach. Learn. 1995, 20, 273–297.

[Google Scholar] [CrossRef]

44.Pedregosa, F.; Varoquaux, G.; Gramfort, A.; Michel, V.; Thirion, B.; Grisel, O.; Blondel, M.; Prettenhofer, P.; Weiss, R.; Dubourg, V.; et al. Scikit-learn: Machine Learning in Python. J. Mach. Learn. Res. 2011, 12, 2825–2830.

[Google Scholar]

45.Pan, S.J.; Yang, Q.A. A Survey on transfer learning. IEEE Trans. Knowl. Data Eng. 2010, 22, 1345–1359.

[Google Scholar] [CrossRef]

46.Prechelt, L. Automatic early stopping using cross validation: Quantifying the criteria. Neural Netw. 1998, 11, 761–767. [Google Scholar] [CrossRef][Green Version]

47.De la Rua, P.; Jaffe, R.; Dall’Olio, R.; Munoz, I.; Serrano, J. Biodiversity, conservation and current threats to European honeybees. Apidologie 2009, 40, 263–284.

[Google Scholar] [CrossRef][Green Version]

48.Klingenberg, C.P. MorphoJ: An integrated software package for geometric morphometrics. Mol. Ecol. Resour. 2011, 11, 353–357.

[Google Scholar] [CrossRef]

49.Büchler, R.; Costa, C.; Hatjina, F.; Andonov, S.; Meixner, M.D.; le Conte, Y.; Uzunov, A.; Berg, S.; Bienkowska, M.; Bouga, M.; et al. The influence of genetic origin and its interaction with environmental effects on the survival of Apis mellifera L. colonies in Europe. J. Apic. Res. 2014, 53, 205–214.

[Google Scholar] [CrossRef][Green Version]

Дополнительные поля статьи

Ссылка на оригинал публикации: https://www.mdpi.com/2504-2289/6/3/70

DOI (Digital Object Identifier): doi: 10.3390/bdcc6030070

Год публикации: 2022

Добавить комментарий